自从deepseek越来越火,官网也是频繁的出现问题,经常出现“服务器繁忙,请稍后再试。”的提示。

其实,我们可以利用deepseek开源的模型,用自己的电脑在本地搭建一个,将模型部署在本地使用。

本文就来教你如何快速,简单的搭建一个模型。

首先准备工作要有:

显卡 显卡 显卡

重要的事情说三遍。

我目前使用的是rtx 2060显卡,实测可以跑7b,8b的模型。

其它配置:cpu/i5 10400f,内存/16gb,电脑系统/win10。

如果你的电脑配置跟我差不多或者比我高,那就可以继续看下去。

如果低一点,可以试试1.5b的模型,应该也能跑,但是必须得要有显卡才行。

教程开始,只需要下面几步,立马就能跑起来你的第一个deepseek模型。

下载并运行Ollama

打开官网网址:https://ollama.com/

下载exe文件包

](/usr/uploads/2025/02/4044711000.png)

这里根据你的操作系统,选择下载相应的包,这里只介绍windows下的教程。

下载好了之后,别忙着安装,因为windows安装包,默认安装在c盘里面,后面下载的模型,也会下载到c盘里面,为了避免c盘容量不够的情况,我们先来进行一个设置,我写了一个bat脚本,你可以把它复制,并且在安装包的同目录下新建一个install.bat文件,把复制的bat脚本复制进去,然后用管理员权限运行一下。

@echo off

chcp 65001 > nul

set "SCRIPT_DIR=%~dp0"

set path=E:/Ollama

setx OLLAMA_MODELS "%path%/models" > nul

setx OLLAMA_HOST "0.0.0.0" > nul

setx OLLAMA_ORIGINS "*" > nul

echo 环境变量已设置成功,下面将进行安装程序,安装页面弹出后,直接点install即可,程序将被安装到%path%

%SCRIPT_DIR%OllamaSetup.exe /DIR="%path%"

pause如果你是小白,不懂编码什么的,复制运行也会出错,那么就到这里下载这个脚本。

https://lovefc.lanzoup.com/ix5Wz2od3cid

下载密码:cur2

上面的path变量就是要安装的目录,你可以更改一下 set path=xxx 这个变量,注意=号后面不能有空格。

不更改脚本的话,你要确保你有E盘。

这个文件要跟刚才下载的安装包放在同一个目录里

](/usr/uploads/2025/02/1289607172.png)

右键点击install.sh,然后选择以管理员身份运行 ](/usr/uploads/2025/02/1717824242.png)

点击之后,如果不出意外,执行后,等待一段时间,就会自动打开ollama的安装页面,直接进行安装就可以了。

](/usr/uploads/2025/02/3239610733.png)

上面的脚本,是添加系统变量和设置安装路径的,如果你会这方面的设置,也可以手动进行设置。

安装好了之后,系统会自动运行ollama,在电脑右下角有个小图标,请将ollama重启一下,关闭后重新打开ollama,如果没有快捷方式,在搜索栏搜索ollama就能看到。

](/usr/uploads/2025/02/2256676637.png)

下载模型

ollama安装好之后,接下来就能下载模型了。

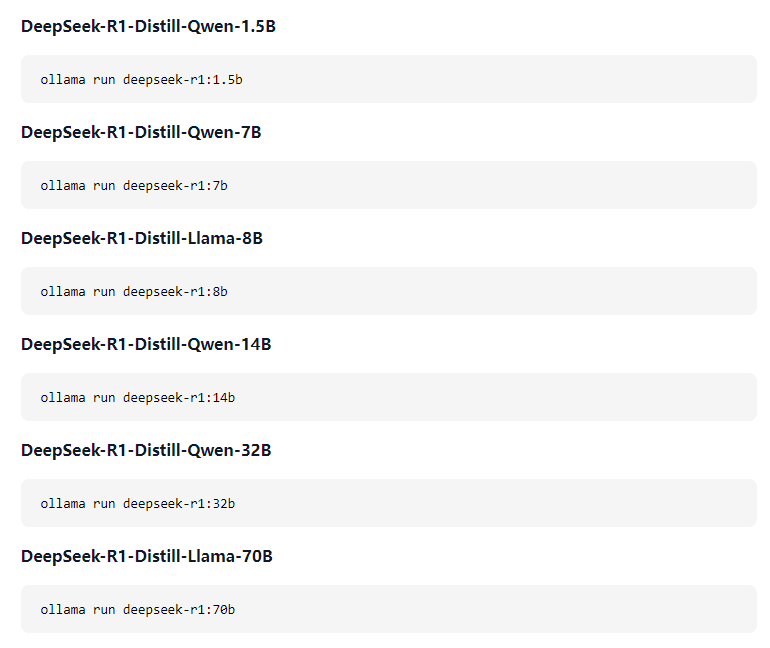

这里我们使用的是deepseek-r1的模型。

模型官方地址:https://ollama.com/library/deepseek-r1

在电脑上重新打开一个cmd窗口或者windows powershell窗口。

](/usr/uploads/2025/02/2297167861.png)

输入命令:ollama help

](/usr/uploads/2025/02/893382484.png)

出现上面的页面,说明操作目前为止都是对的。

ollama 命令,我们目前只要记住这三个就可以了:

查看模型列表:ollama list

安装模型:ollama run xxxx

卸载模型:ollama rm xxxx

下载模型,直接输入命令就可以了。

比如我使用的是8b的模型,就在cmd里面直接输入ollama run deepseek-r1:8b

这里给大家一个参考,请根据你的显卡下载相应的模型。

| 模型名称 | 显存需求 | 显卡推荐 |

|---|---|---|

| DeepSeek-R1 1.5B | 约 1 GB | GTX 1050 及以上 |

| DeepSeek-R1 7B | 约 4 GB | RTX 3060 及以上 |

| DeepSeek-R1 8B | 约 4.5 GB | RTX 3070 及以上 |

| DeepSeek-R1 14B | 约 8 GB | RTX 4070 及以上 |

| DeepSeek-R1 32B | 约 18 GB | RTX 4080 及以上 |

| DeepSeek-R1 70B | 约 40 GB | RTX 4090 或 A100 |

接下来就是等待下载,下载好了之后会直接运行。

](/usr/uploads/2025/02/593978476.png)

你可以直接在命令行里面输入问题,让他解答。

使用可视化ai工具

模型安装好了,不能总是在命令行里面使用,所以我们需要一个ai工具来配合我们使用。

不想折腾的,推荐chatbox,使用非常简单。

下载Windows,然后安装。下载好之后,选择自己的模型或者在设置里面设置一下。

](/usr/uploads/2025/02/1387641345.png)

需要注意的是,我在上面就已经把ollama服务配置好了,就是上面的变量设置,所以这里不用在进行其它设置。

直接选择模型提供方:OLLAMA API,

API域名填写:http://127.0.0.1:11434

然后模型选择一下就可以了。

接着,就可以愉快的使用了,输入问题后,可能要等待一会才出结果,这是正常情况,具体速度看你模型的大小和电脑配置。

](/usr/uploads/2025/02/2210065720.png)

另外,如果你是一个略微懂些编程的人,还可以使用:https://github.com/jakobhoeg/nextjs-ollama-llm-ui

](/usr/uploads/2025/02/1947173952.png)

这个网页ui库进行可视化管理,它可以让你在网页轻松的使用本地模型。

另外还有一个非常简单,友好的chrome浏览器插件-page-assist

可以到这个页面去下载-https://github.com/n4ze3m/page-assist/releases/tag/v1.5.2

以上,便是本地部署deepseek-r1模型的全部教程,希望能够帮到你。